Perception des donateurs à l’usage de l’IA par les OSBL – Etude 2025 – FundraisingAI (USA)

Perception des donateurs à l’usage de l’IA par les OSBL – Etude 2025 – FundraisingAI (USA)

Publié le 15 décembre 2025

En 2025, les donateurs abordent l’IA avec un optimisme conditionnel. Ils reconnaissent le potentiel de l’IA pour renforcer la collecte de fonds, améliorer l’efficacité opérationnelle et prouver l’impact des actions. Cependant, ils exigent le même niveau de rigueur et de responsabilité qu’ils attendent de toutes les facettes de la vie associative. L’ère de la nouveauté est révolue, remplacée par une familiarité croissante, et l’anxiété a cédé la place à un intérêt plus aiguisé. La question centrale n’est plus de savoir si les organisations à but non lucratif doivent utiliser l’IA, mais si elles peuvent le faire de manière responsable. Décryptage avec l’édition 2025 de l’étude de FundraisingAI.

Le collectif FundraisingAI vient de sortir l’édition 2025 de leur étude sur la perception des donateurs sur l’usage de l’IA par les OSBL « Donor Perceptions of AI 2025 », réalisé par Cherian Koshy et Chappell. Cette étude a adopté une approche quantitative, interrogeant 1 031 individus ayant effectué des dons au cours des 12 derniers mois, aux Etats Unis. L’étude a été menée en août 2025. Les répondants ont été questionnés sur leur familiarité avec l’IA, leurs préoccupations concernant son utilisation dans les associations, les avantages perçus, ainsi que son impact potentiel sur leur comportement de don. Télécharger l’édition 2024 et 2025 de l‘étude ici. Décryptage en 4 parties :

- Quelles évolutions des mentalités des donateurs sur l’IA et l’usage de l’IA par les OSBL entre 2024 et 2024 ?

- Les apprentissages clés pour 2025 – Etablir la confiance et démontrer l’efficacité

- Adapter les stratégies à la diversité des donateurs

- Conclusion : Feuille de route pour l’adoption responsable de l’IA en philanthropie selon les auteurs de l’étude

Quelles évolutions des mentalités des donateurs sur l’IA et l’usage de l’IA par les OSBL entre 2024 et 2024 ?

L’analyse comparative avec l’étude de l’année précédente (2024) met en lumière des changements cruciaux dans la psychologie du donateur, qui signalent que la sensibilisation accrue remodèle les attentes. L’exposition à l’Intelligence Artificielle est désormais un phénomène courant dans la base des donateurs.

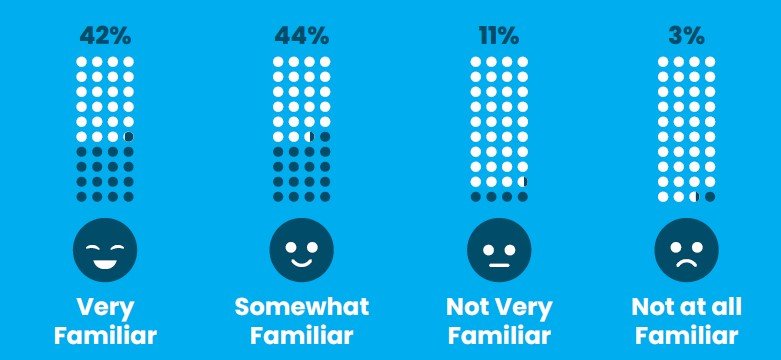

Huit donateurs sur dix (86 %) déclarent comprendre l’IA au moins « quelque peu ». La familiarité du donateur avec l’IA a connu une croissance notable entre 2024 et 2025. Le pourcentage de donateurs se déclarant « très familiers » avec l’IA a bondi de 10 points de pourcentage d’une année sur l’autre, passant de 32 % en 2024 à 42 % en 2025, Ce niveau de familiarité plus élevé est le moteur du passage d’une curiosité axée sur les risques à une position d’optimisme conditionnel.

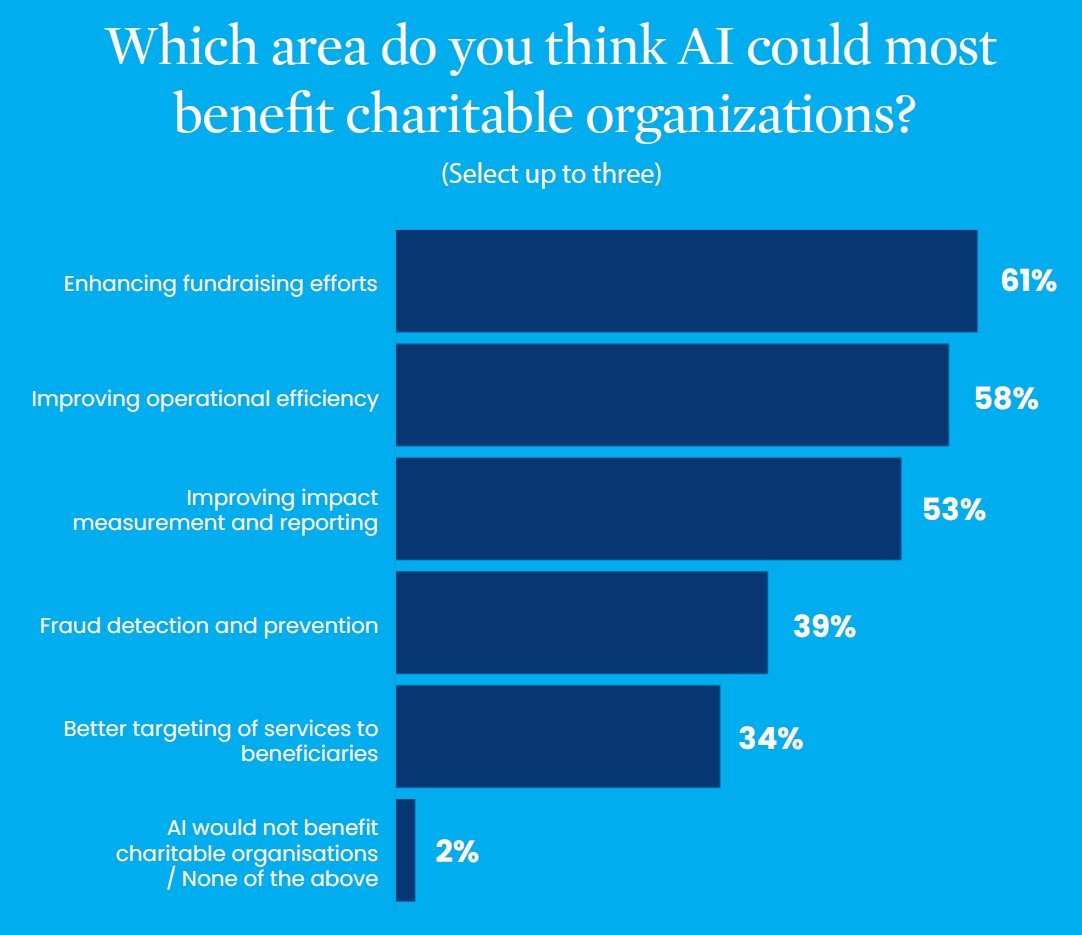

Le changement le plus significatif concerne la perception des bénéfices potentiels de l’IA. Alors qu’en 2024, la détection des fraudes et l’efficacité opérationnelle étaient les avantages perçus dominants, en 2025, les priorités se sont inversées pour se concentrer sur la croissance et les résultats :

- L’amélioration des efforts de collecte de fonds (61 %) est devenue le principal avantage perçu, dépassant de peu l’amélioration de l’efficacité opérationnelle (58 %). Ce changement est fondamental : les donateurs associent désormais l’IA à la croissance des revenus, et non plus uniquement à la gestion des risques.

- L’amélioration de la mesure et du rapport d’impact (53 %) a augmenté de près de 20 points par rapport à l’année précédente. Cela témoigne d’une attente croissante des donateurs à ce que l’IA fournisse des preuves tangibles de l’efficacité des organisations.

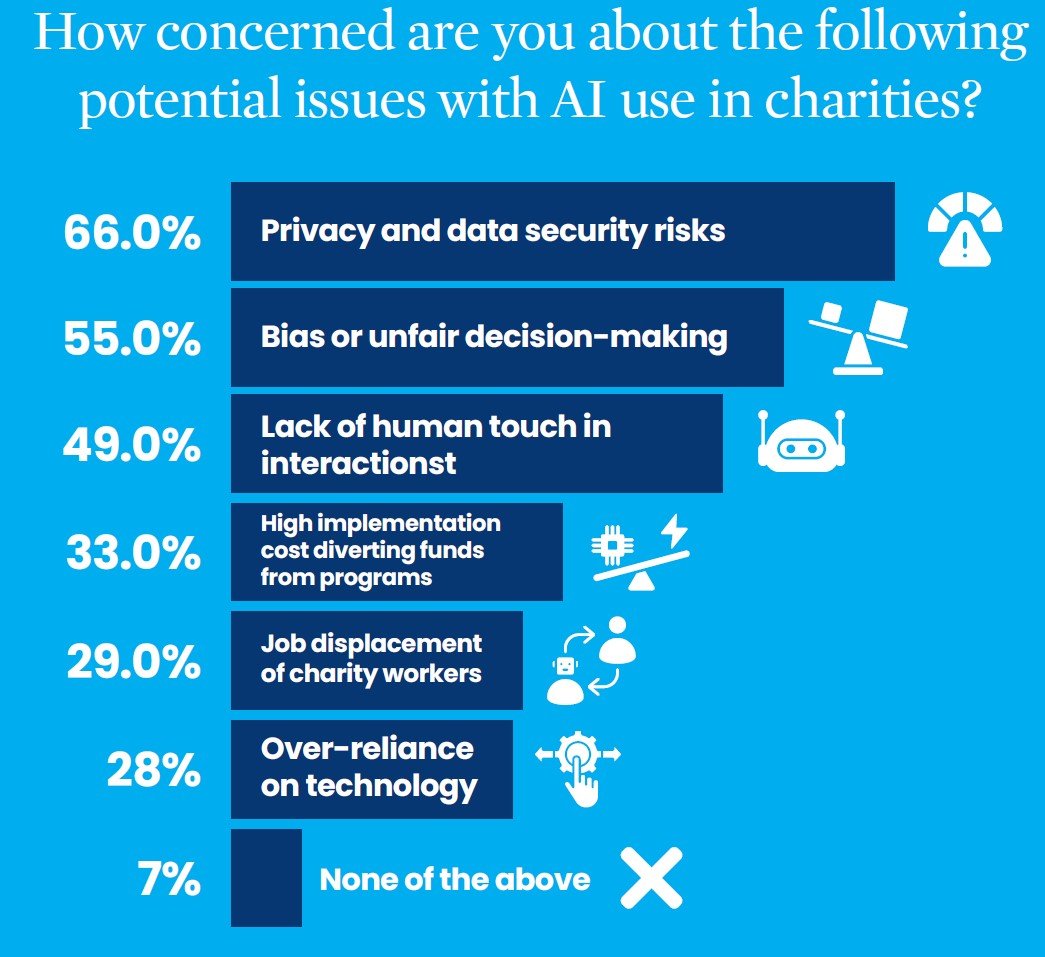

Si certaines préoccupations restent constantes (la transparence et la sécurité des données), l’accent mis sur les risques a évolué. L’anxiété concernant la « perte de contact humain » (qui était à égalité pour la première place en 2024) a diminué, tombant à 49 % en 2025. En revanche, l’inquiétude concernant les biais algorithmiques et la prise de décision injuste a grimpé à 55 %, se hissant à la deuxième place. Cela indique que l’angoisse liée au manque d’empathie est en recul, tandis que les préoccupations éthiques concernant l’équité et la justice sont en forte progression.

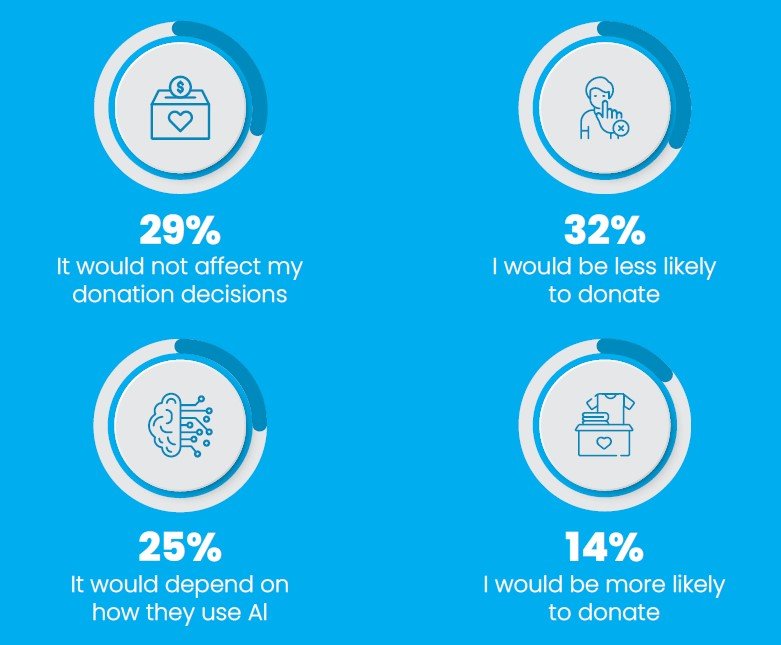

L’adoption de l’IA par une organisation demeure un facteur de risque pour la réputation, mais la résistance globale s’est légèrement atténuée. Alors que 32 % des donateurs déclarent qu’ils donneraient moins à une organisation utilisant l’IA, 14 % affirment qu’ils donneraient plus. Le solde net de l’impact sur les dons, bien que toujours négatif, est passé de -22 points en 2024 à -18 points en 2025. Cela signifie que les faux pas risquent toujours d’aliéner les donateurs, mais qu’une approche réussie et transparente peut débloquer un soutien supplémentaire.

Les apprentissages clés pour 2025 – Etablir la confiance et démontrer l’efficacité

Les professionnels des associations et fondations doivent intégrer ces nouvelles perceptions dans leurs stratégies. Les donateurs veulent que l’IA rende les organisations plus intelligentes dans leur gestion et plus performantes dans leur collecte de fonds.

La transparence est considérée comme fondamentale par la quasi-totalité des donateurs : 92 % des donateurs la jugent importante. Les attentes spécifiques en matière de transparence sont très claires et doivent être satisfaites de manière proactive pour maintenir la confiance :

- Clarté de l’utilisation : 73 % des donateurs exigent une explication claire et publique, sur le site web de l’organisation, décrivant où et pourquoi l’IA est utilisée. Une communication claire et sans jargon est essentielle.

- Contrôle humain : 63 % insistent sur l’assurance que les décisions de l’IA sont examinées par des humains. Ceci fait écho à l’anxiété des donateurs face à la délégation de décisions critiques (comme l’allocation des subventions) aux algorithmes seuls.

- Preuve de performance : Une majorité (56 %) souhaite des preuves que l’IA améliore réellement l’efficacité ou l’impact de l’organisation. La transparence doit donc porter sur les résultats, pas seulement sur les processus.

- Options de contrôle : De nouvelles attentes émergent, notamment la possibilité de refuser les interactions pilotées par l’IA (option d’opt-out, demandée par 52 %) et la mise en œuvre d’audits par des tiers des systèmes d’IA (48 %).

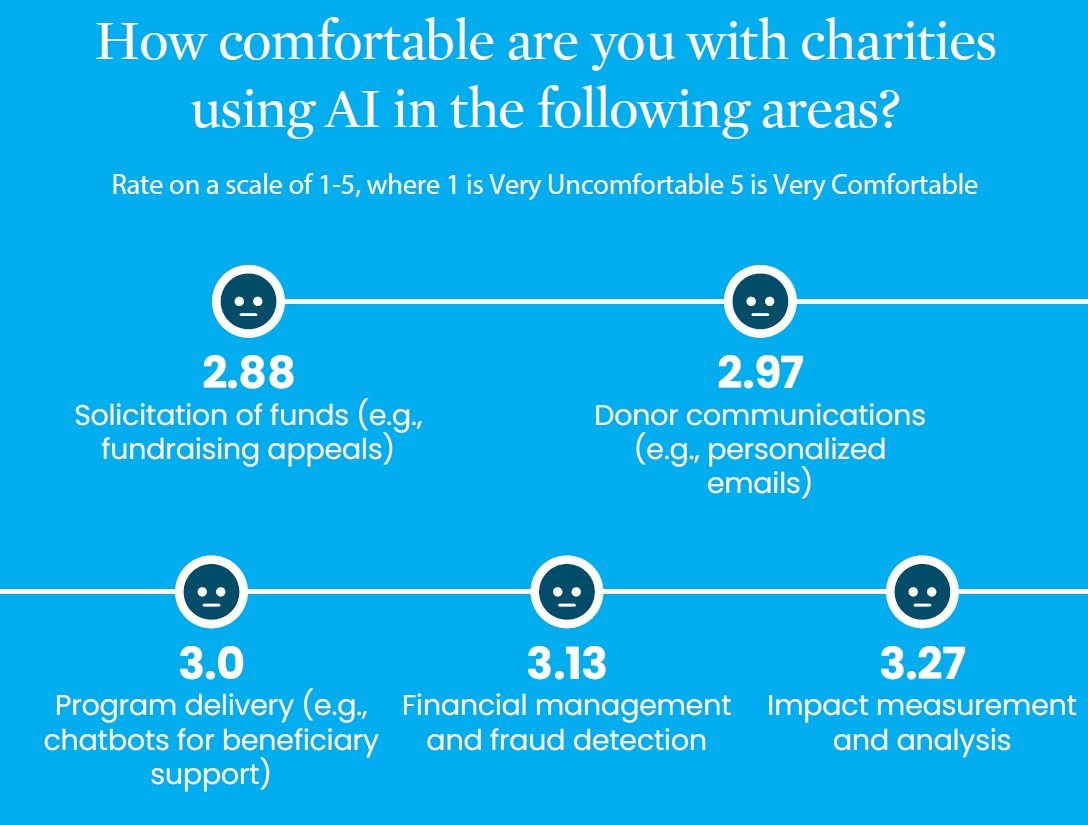

Les donateurs sont beaucoup plus à l’aise lorsque l’IA gère les données et renforce la gestion interne. Les utilisations les plus fiables et appropriées sont :

- Mesure et analyse de l’impact (54 % jugent cela « approprié »).

- Gestion financière et détection des fraudes (50 % trouvent cela « approprié »).

Cependant, l’IA dans les interactions directes avec les donateurs suscite l’ambivalence. La sollicitation de dons est l’utilisation la moins bien perçue, avec 44 % des donateurs la trouvant « inappropriée » contre 42 % qui la trouvent « appropriée ». Les communications personnalisées par e-mail générées par l’IA recueillent également un soutien mitigé.

Les donateurs tracent des limites éthiques nettes. Les professionnels doivent absolument éviter les pratiques qui masquent l’identité de la machine.

- L’usurpation d’identité est le danger principal : L’inquiétude dominante (nommée par environ un tiers des donateurs comme leur principale préoccupation) est l’utilisation de « bots IA dépeints comme des humains représentant une organisation caritative ». La moitié des répondants placent cette préoccupation dans leurs trois principales, ce qui en fait la ligne rouge éthique la plus claire. Toute pratique qui semble trompeuse autour de l’identité est à proscrire absolument.

- Remplacement du jugement Humain : Les donateurs sont également mal à l’aise lorsque les algorithmes remplacent le jugement humain dans les décisions critiques, comme l’allocation automatisée des subventions. Cela est classé parmi les principales préoccupations, car cela fait écho aux débats publics sur l’équité et le biais de l’IA.

Deux tiers des donateurs (66 %) craignent toujours les risques de confidentialité et de sécurité des données (données des donateurs ou des bénéficiaires exposées ou utilisées à mauvais escient). C’est le principal critère d’évaluation des donateurs. De plus, 55 % s’inquiètent de la possibilité que les algorithmes introduisent des biais ou des préjugés dans la prise de décision. Pour contrer ces craintes, les organisations doivent mettre en avant leurs atouts en matière de protection des données (chiffrement, audits de conformité) et démontrer des mesures d’atténuation des biais, en gardant toujours les humains visibles pour examiner les résultats de l’IA.

Adapter les stratégies à la diversité des donateurs

L’étude révèle des nuances importantes dans la perception de l’IA selon les segments de donateurs. L’approche d’adoption de l’IA doit être segmentée et progressive.

L’âge et la familiarité (avec l’IA) sont les principaux facteurs de polarisation :

- Enthousiasme chez les plus jeunes et les plus familiers avec l’IA : L’enthousiasme se concentre chez les donateurs les plus familiers avec l’IA (le groupe « très familier » est le seul segment où les réponses positives dépassent les négatives concernant l’impact sur le don) et chez la tranche d’âge la plus jeune. Par exemple, 24 % des donateurs de la Gen Z (18-29 ans) sont plus susceptibles de donner à une organisation utilisant l’IA, et 30 % apprécient la personnalisation.

- Résistance chez les plus âgés : La résistance culmine chez les cohortes plus âgées et ceux qui ne sont que vaguement familiers avec la technologie. À partir de 45 ans, l’enthousiasme diminue considérablement. Seuls 9 % des Boomers (60-75 ans) sont plus susceptibles de donner, et chez les 75 ans et plus, ce chiffre tombe à 2 %. L’inconfort actif face à la personnalisation dépasse 50 % chez les donateurs les plus âgés (75+).

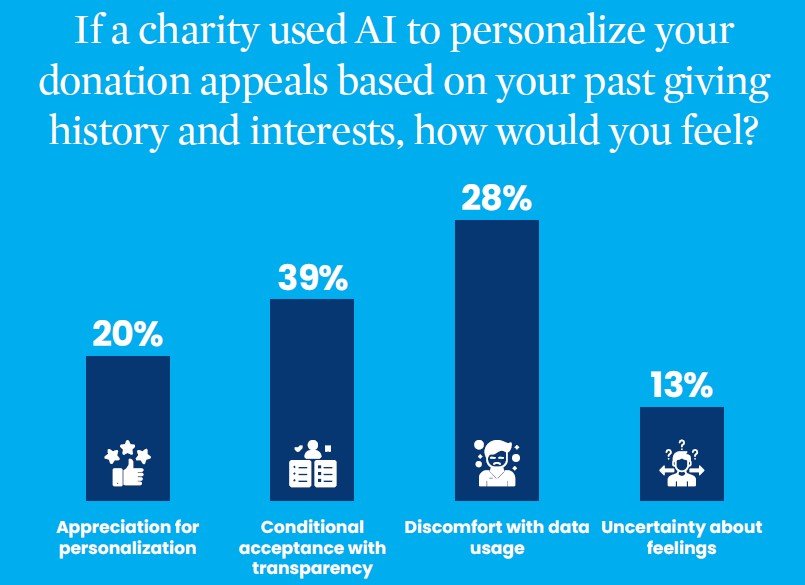

L’utilisation de l’IA pour personnaliser les appels de dons en fonction de l’historique et des intérêts du donateur est une tactique polarisante.

- Acceptation conditionnelle : Près de la moitié des donateurs (48 %) sont ouverts à la personnalisation. 20 % l’apprécieraient directement, tandis que 28 % l’accepteraient à condition d’être informés (transparence conditionnelle).

- Inconfort significatif : Cependant, une forte minorité (39 %) se sentirait mal à l’aise avec cette utilisation de leurs données

Pour gérer cette polarisation, l’étude suggère de toujours commencer par une explication claire de la manière dont les données sont utilisées et sécurisées. Il est crucial d’offrir une option d’opt-out facile pour ceux qui préfèrent des appels génériques. Les organisations à but non lucratif peuvent commencer par tester des appels améliorés par l’IA auprès des donateurs « très familiers » pour maximiser les avantages et recueillir des preuves de réussite avant d’élargir la portée.

Conclusion : Feuille de route pour l’adoption responsable de l’IA en philanthropie selon les auteurs de l’étude

L’étude 2025 marque une étape décisive : les donateurs sont passés d’une posture de méfiance générale à celle d’observateurs pragmatiques. Ils sont prêts à récompenser les organisations qui utilisent l’IA pour devenir de meilleurs gestionnaires et de meilleurs collecteurs de fonds, à condition que les organisations respectent un ensemble strict de règles éthiques et de transparence.

Les principaux enseignements pour les professionnels de la générosité sont les suivants :

- Prioriser l’impact et les gains financiers : Le récit doit se concentrer sur la manière dont l’IA augmente la collecte de fonds et améliore la preuve d’impact (61 % et 53 %). L’efficacité opérationnelle (58 %) reste cruciale, mais l’histoire d’une IA au service de la mission passe avant celle de la simple réduction des coûts administratifs.

- Faire de la confiance un pilier opérationnel : La sécurité des données (66 %) et la transparence absolue (92 %) sont des normes incontournables. La communication sur la manière dont l’IA est supervisée, auditée (48 %) et revue par des humains (63 %) est fondamentale.

- Encadrer l’IA pour augmenter l’humain, non le remplacer : Évitez toute anthropomorphisation des bots et assurez-vous que les décisions critiques (particulièrement l’allocation des fonds) restent sous supervision humaine visible. Le cadrage de l’IA doit mettre en évidence comment la technologie augmente, plutôt que remplace, le personnel et les relations personnelles.

- Éduquer pour convertir : Étant donné que la familiarité avec l’IA réduit l’anxiété et augmente la propension à donner, les organisations doivent fournir des études de cas claires et accessibles démontrant comment l’IA génère des avantages concrets.

En définitive, le chemin vers une adoption réussie de l’IA dans la philanthropie passe par une transparence radicale et une démonstration crédible que l’IA est utilisée pour le bien, dans le respect de l’équité et de la dignité humaine. C’est en respectant ces conditions que les associations et fondations pourront transformer le scepticisme en un soutien durable de la part d’une communauté de donateurs de plus en plus avertie technologiquement.